Der künstlichen Intelligenz kann man derzeit zusehen, wie sie einen Quantensprung nach dem anderen macht. Deep Learning ist das neueste und fragwürdigste Schlagwort. Erinnern wir uns an Googles DeepDream. Es zeigte angeblich, wovon Androiden träumen, indem es algorithmische Pareidolien (also Gesichtserkennung in Mustern) durch ein künstliches neuronales Netz laufen ließ. Oder denken wir an AlphaGo, das den koreanischen Großmeister Lee Sedol in einem historischen Go-Turnier besiegte. Diese künstlichen Intelligenzen sind so leistungsfähig, weil sie inzwischen auch so komplex sind, dass es für uns Bewohner der Benutzeroberfläche immer schwieriger wird, die schwachen Signale aus den Tiefen ihrer ozeanischen Gehirne aufzufangen. Alle großen Konzerne – Google, Facebook, Microsoft, Baidu, Amazon, Apple, IBM und andere – bauen derzeit ihre gesamte Infrastruktur neu auf Deep Learning auf. Bei Google heißt das bezeichnenderweise „DistBelief“.

Jede Internetsuche, jedes hochgeladene und getaggte Bild, tatsächlich jegliche Eingabe im Internet dient gegenwärtig dem Training – man könnte sogar sagen: der Erziehung – von Schichten um Schichten von Algorithmen. Die winzigen Oberflächen – ein bizarres DeepDream-Bildchen oder die Fernsehübertragung eines Go-Spiels – verbergen nur einen groß angelegten Strukturumbau, infolgedessen der größere Teil allen Lesens, Schreibens und Verarbeitens von Maschine zu Maschine erledigt wird, während die Menschen als Datenfütterer, Lieferanten von Inhalten und Pfleger nur noch eine zweitrangige Rolle spielen.

Die von Google als Open Source veröffentlichte Softwarebibliothek TensorFlow bildet die Basis für das Machine Learning auf verschiedenen Gebieten des Wahrnehmungs- und Sprachverstehens. Ein Akt, der den Open-Source-Gedanken gewissermaßen auf den Kopf stellt: Google hat einfach seine Nutzer- und Datenbank erheblich erweitert und profitiert zusätzlich von kostenloser Rückkopplung und Fehlerbeseitigung. Noch handelt es sich bei TensorFlow nicht um eine unkontrollierte Künstliche Intelligenz im Internet. Aber es ist ein wesentlicher, sorgfältig kalkulierter Schritt in diese Richtung.

Nach Google hat auch der chinesische Internetriese Baidu sein Toolkit Paddle (Parallel Distributed Deep Learning) als Open-Source-Programm veröffentlicht. Dies ist Ausdruck eines globalen Infrastrukturwandels und ein Hinweis darauf, dass Deep Learning nicht nur ernst genommen, sondern unter anderem bereits eingesetzt wird, um das Problem der Evaluierung riesiger Mengen komplizierter, von Konzernen und Nachrichtendiensten erhobener Daten zu bewältigen. Auch Facebook investiert unter dem Namen FAIR (Facebook Artificial Intelligence Research) zunehmend in spezialisierte Hardware (nicht zu reden von den Aquila-Drohnen und dem Terragraph-Projekt für weltweiten Zugang zum Internet, d. h. für noch mehr Daten zur weiteren Verarbeitung).

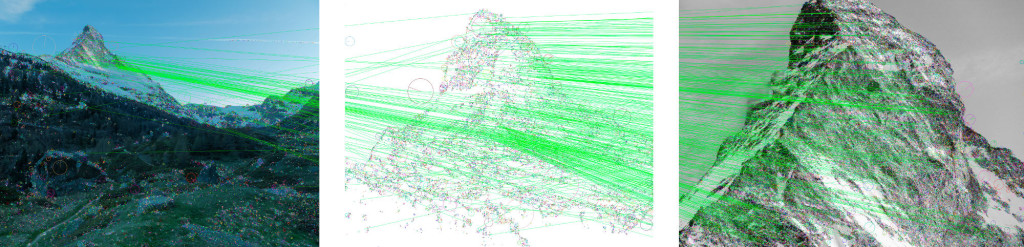

Trevor Paglen ruft ein paar verschwommene Bilder auf, die ein menschliches Auge kaum deuten kann: Farbkleckse, unscharfe Ränder, kaum Kontraste oder Formen. „So wird die Welt der künstlichen Intelligenz aussehen. Es geht um Objekterkennung, und das sind die Übungsbilder, mit denen sie trainiert wird.“ Genutzt wurde dafür ImageNet, eine riesige Datenbank mit gegenwärtig mehr als 14 Millionen Bildern für Forschungszwecke. „Ich weiß auch nicht, wie viele Klassifikatoren innerhalb von Kategorien von Objekten sie enthält. So sieht es aus, wenn eine Maschine den Inhalt eines Bildes interpretiert, und genau das passiert auch im Hintergrund bei Facebook und Google.

Wenn man eine künstliche Intelligenz trainiert, sagt man ihr: Hier hast du 10.000 Bilder eines Goldfischs, 10.000 Bilder der Sonne, 10.000 Bilder einer Orange. Finde heraus, was sie unterscheidet. Dann erstellt das System intern eine Art Archetyp dessen, was es für das mit größter Wahrscheinlichkeit erwartbare Aussehen des Objekts hält. Das hier ist beispielsweise der Archetyp eines Goldfischs.“ Was Paglen Archetyp nennt, ist von Jung’schen Gestaltkonzepten sehr weit entfernt. Computerarchetypen, erläutert er, entstehen, indem die Rechner „für jedes Pixel im Bild von einem Goldfisch mit 90-prozentiger Wahrscheinlichkeit eine bestimmte Farbe und Helligkeit ermitteln. Das ist ein unglaublich präzises Bild. Facebook-Algorithmen nutzen DeepFace zur Gesichtserkennung, und sie entschlüsseln Gesichter und menschliche Figuren schon jetzt viel besser als jeder Mensch. Diese Algorithmen sind so gut, weil sie so viele Daten zur Verfügung haben. Milliarden Menschen tragen zu den Beständen bei, und zwar jedes Mal, wenn sie ein Bild taggen.“

Wir gehen zu einem anderen Rechner und laden ein Programm. Es betrachtet uns durch die Webcam und zeigt in einer Bildermatrix von Neuronen alle Schritte und Schichten der Kognition und Verarbeitung im neuronalen Netzwerk. Wir tragen beide schwarze T-Shirts, die das Programm als kugelsichere Westen interpretiert. Wir bewegen uns eine ganze Weile vor der Kamera auf und ab und tauschen Blicke mit dieser neuen Art von Wesen, mit seinen blinkenden Neuronen und dieser Art, uns anzusehen.

Im Jahr 1936 stellte der Mathematiker und Marathonläufer Alan M. Turing die Frage, ob Maschinen denken können. In Beantwortung dieser Frage begann er, eben die Maschine zu bauen, die nun Trevor und mich ansieht. Zur selben Zeit wie Turing präsentierte der Psychoanalytiker und/oder delirante Dandy Jacques Lacan seine Vorstellung eines „Spiegelstadiums“. Vom 6. bis zum 18. Lebensmonat beginnt demnach ein Säugling, seine eigene Konstitution als Subjekt zu begreifen, indem er sich selbst als Ganzes im Spiegel erkennt. Davor ist das Bild seiner selbst unzusammenhängend, fragmentiert, zerstückelt. Es existiert nur als lose Ansammlung seiner Teile. Erst im Spiegelstadium wird es zu einem Individuum.

Seine Teile fügen sich zu einer funktionalen, zentral gesteuerten Einheit, allerdings nur in einer, wie man sagen könnte, „realen Virtualität“. Das Subjekt bildet ein Ich, um unmittelbar darauf wieder in seine Einzelteile zerstückelt zu werden. Es schwankt unablässig zwischen Sein und Nichtsein – und dies ist nach Lacan auch seine eigentliche Grundbedingung, die flimmernde „Skandierung“, also bewusst betonte Unterbrechung des Seins in der imaginären Ordnung: da, fort. Gespiegelt, ein weiteres Mal, im digitalen Ein und Aus.

Ein paar Jahrzehnte später schrieb ein gewisser Yann LeCun – der Name erinnert an eine schlechte Spracherkennung von Jacques Lacan – gemeinsam mit seinem Kollegen John S. Denker 1990 in den AT&T Bell Laboratories an einem wissenschaftlichen Artikel, in dem es um einen besonderen Optimierungsvorschlag für neuronale Netze ging. Er erhielt den Namen „Optimal Brain Damage“, und sein Urheber leitet inzwischen die gesamte Forschung zur künstlichen Intelligenz bei Facebook.

Dieser bestmögliche Hirnschaden – ein Gehirn mit hochgradiger Spezialisierung, in dem alle redundanten Nervenverbindungen gekappt sind – versucht nun, im Jahr 2016, uns zu erkennen. Einzelne Neuronen suchen nach Details, auf die sie trainiert sind: Goldfisch, Sonne, Duschhaube, kugelsichere Weste. Die Maschine erschafft sich eindeutig selbst als etwas – vielleicht nicht gleich als ein Ich, aber wer sagt eigentlich, dass ein Ich notwendig ist?

„Google DeepDream ist eine Art Mystifizierung insofern“, sagt Paglen, „als es aus diesen Verfahren wieder ein Bild entstehen lässt, aber nicht über das spricht, was hinter DeepDream vor sich geht. Tatsächlich ist DeepDream Teil einer sehr viel größeren Infrastruktur mit dem Zweck, so viel Profit wie möglich aus den winzigsten alltäglichen Wechselwirkungen zu schlagen. DeepDream muss eigentlich nichts berechnen, sondern Geld verdienen. Hier geht es um die Mikro-Interaktionen in unserem Leben, die der Kapitalismus bisher nicht durchdringen konnte.

Dem Kapitalismus ist es bis vor Kurzem nicht gelungen, eine Familie zu crashen, die gemeinsam am Tisch sitzt und sich gegenseitig Fotos zeigt. Aber jetzt kann er das, und er zieht Profit aus noch feineren Schichten menschlichen Lebens, wie auch aus noch intimeren gesellschaftlichen Verhältnissen. Er kann sie quantifizieren, also in Geld umrechnen. Besonders heimtückisch daran ist, dass Big Data die elementaren menschlichen Beziehungen ausbeutet. Jeder will Bilder von seinen Kindern und ihren Freunden herumzeigen. Etwas Menschlicheres kann ich mir kaum vorstellen. Facebook hat mit einem Arsenal digitaler Waffen ein Geschäft daraus gemacht. Das Letzte, was man tun sollte, ist auf Facebook Fotos von seinen Kindern zeigen.“